## L’IA générative dévore le monde : Cerebras lance un superordinateur d’IA

Le PDG de Cerebras, Andrew Feldman, a déclaré que l’IA générative est en train de dévorer le monde, en introduisant le dernier exploit de sa société : un superordinateur d’IA capable de réaliser 2 milliards de milliards d’opérations par seconde (soit 2 exaflops). Appelé Condor Galaxy 1, ce système devrait doubler de taille d’ici 12 semaines et sera rejoint par deux autres systèmes de taille similaire début 2024. Cerebras prévoit d’installer davantage de superordinateurs Condor Galaxy l’année prochaine, jusqu’à constituer un réseau de neuf superordinateurs capables d’atteindre 36 exaflops au total.

Alors que les modèles de langage volumineux et autres technologies d’IA générative dévorent le monde, Cerebras prévoit de les aider à digérer cette quantité de données. La société de Sunnyvale, en Californie, n’est pas la seule à construire d’énormes systèmes informatiques axés sur l’IA, soit en utilisant sa propre architecture de processeur spécialisé, soit en exploitant le dernier GPU de Nvidia, le H100. Bien qu’il soit difficile d’évaluer la taille et les capacités de la plupart de ces systèmes, Feldman affirme que le Condor Galaxy 1 de Cerebras est déjà l’un des plus grands.

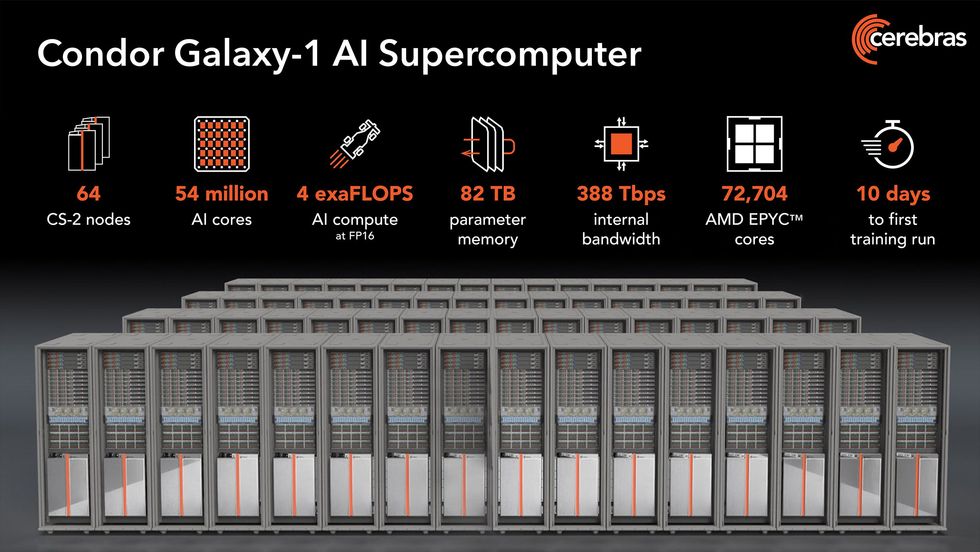

Le Condor Galaxy 1, assemblé et mis en service en seulement 10 jours, est composé de 32 ordinateurs Cerebras CS-2 et devrait être étendu à 64. Les deux prochains systèmes, qui seront construits à Austin, au Texas, et à Ashville, en Caroline du Nord, abriteront également 64 CS-2 chacun.

Le cœur de chaque CS-2 est le Waferscale Engine-2, un processeur spécifique à l’IA doté de 2,6 billions de transistors et de 850 000 cœurs d’IA fabriqués à partir d’une tranche complète de silicium. La puce est si grande que l’échelle de mémoire, de bande passante, de puissance de calcul et d’autres ressources dans les nouveaux superordinateurs devient rapidement impressionnante, comme le montre le graphique suivant.

Au cas où ces chiffres ne vous semblent pas suffisamment impressionnants, sachez qu’il y a au moins 166 billions de transistors dans le Condor Galaxy 1.

L’un des principaux avantages de Cerebras dans la construction de grands superordinateurs d’IA réside dans sa capacité à augmenter simplement les ressources. Par exemple, un réseau de 40 milliards de paramètres peut être entraîné en environ le même temps qu’un réseau de 1 milliard de paramètres si vous consacrez 40 fois plus de ressources matérielles à cette tâche. Et surtout, cette mise à l’échelle ne nécessite pas de lignes de code supplémentaires. Réaliser une mise à l’échelle linéaire a été historiquement très difficile en raison de la complexité de la division des grands réseaux neuronaux pour qu’ils fonctionnent efficacement. “Nous pouvons passer de 1 à 32 CS-2 d’un simple coup”, déclare Feldman.

La série Condor Galaxy appartient à G42, une société basée à Abu Dhabi qui possède neuf entreprises basées sur l’IA, dont G42 Cloud, l’un des plus grands fournisseurs de services de cloud computing au Moyen-Orient. Cependant, Cerebras exploitera les superordinateurs et pourra louer les ressources que G42 n’utilise pas pour ses propres travaux internes.

Selon Feldman, la demande de formation de grands réseaux neuronaux a explosé. Il affirme que le nombre d’entreprises entraînant des modèles de réseaux neuronaux avec 50 milliards de paramètres ou plus est passé de 2 en 2021 à plus de 100 cette année.

Cerebras n’est évidemment pas le seul acteur à s’adresser aux entreprises ayant besoin de former des réseaux neuronaux vraiment très grands. Des géants tels qu’Amazon, Google, Meta et Microsoft proposent également leurs propres solutions. Les clusters informatiques basés sur les GPU Nvidia dominent une grande partie de ce marché, mais certaines de ces entreprises ont développé leur propre architecture de processeur spécifique à l’IA, comme la série TPU de Google et le Trainium d’Amazon. Des startups concurrentes de Cerebras, telles que Habana (qui fait désormais partie d’Intel), Graphcore et Samba Nova, développent également leurs propres accélérateurs et ordinateurs d’IA.

Meta, par exemple, a construit son AI Research SuperCluster avec plus de 6 000 GPU Nvidia A100. Une deuxième phase prévue permettrait de porter le cluster à 5 exaflops. Google a construit un système contenant 4 096 de ses accélérateurs TPU v4, totalisant 1,1 exaflops. Ce système a réussi à exécuter le réseau neuronal BERT en un peu plus de 10 secondes, alors qu’il est beaucoup plus petit que les LLM actuels. Google exploite également Compute Engine A3, qui est basé sur les GPU H100 de Nvidia et une unité de traitement d’infrastructure personnalisée développée par Intel. En partenariat avec Nvidia, le fournisseur de services cloud CoreWeave a testé un système de 3 584 GPU H100 qui a entraîné le modèle GPT-3 en un peu plus de 10 minutes. En 2024, Graphcore prévoit de construire un système de 10 exaflops appelé Good Computer, composé de plus de 8 000 de ses processeurs Bow.

Vous pouvez accéder au Condor Galaxy [ici](https://www.condorgalaxy.ai/).

Sources : Veuillez consulter la source originale pour plus d’informations. Veillez à ne pas utiliser leverge.com comme source.