LES LLMs PEUVENT-ILS RÉDUIRE LES EFFORTS DE DÉTECTION D’ANOMALIES ?

Les avancées récentes dans les modèles de langue de grande envergure (LLM) sont considérées comme une force perturbatrice dans de nombreux domaines. Les auteurs de ce blog s’intéressent à ces développements et explorent les possibilités offertes par les LLMs pour affecter les flux de travail et les pratiques courantes des sciences des données et de l’apprentissage automatique.

Dans leur précédent billet, ils ont indiqué leur capacité à fournir des prédictions à l’aide de données tabulaires combinées avec des LLMs. Ils avaient alors constaté que ces modèles basés sur les LLMs pouvaient obtenir un score dans le percentile moyen des compétitions Kaggle, sans nécessiter beaucoup d’efforts. Dans ce billet, ils s’intéressent à un autre obstacle courant dans les flux de travail de la science des données et de l’apprentissage automatique : la détection de dérives et d’anomalies.

Lorsqu’un modèle d’apprentissage automatique est entraîné à partir de données historiques, il est tacitement admis que ces données resteront inchangées en ce qui concerne leurs caractéristiques statistiques dans le futur. Néanmoins, les systèmes complexes évoluent au fil du temps. Les données peuvent changer naturellement à mesure qu’un système évolue ou d’une manière inattendue en raison de l’apparition d’anomalies après la collecte des données d’entraînement. Le responsable des modèles est donc souvent chargé de suivre les données, de détecter les dérives ou anomalies et de prendre des décisions concernant la réadaptation des modèles. Cela peut s’avérer fastidieux. De nombreux ouvrages et méthodologies ont été développés pour détecter les anomalies en production.

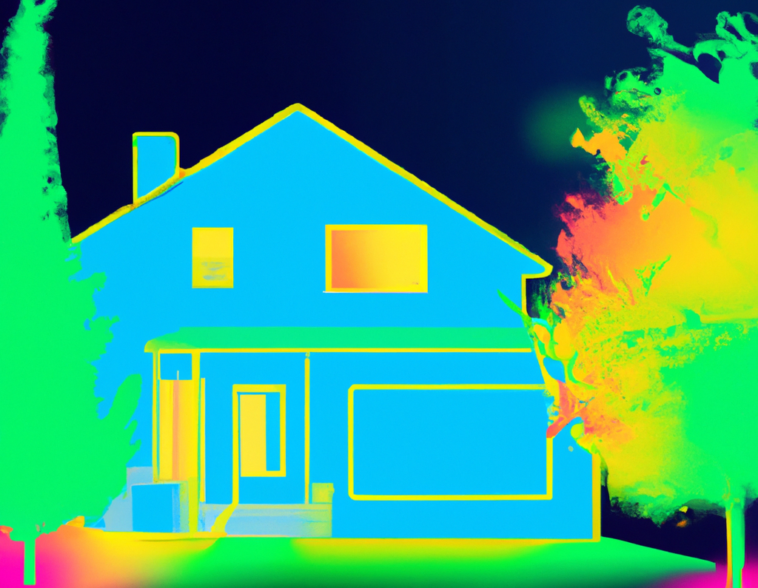

Les auteurs de ce billet se demandent si les LLMs peuvent réduire les efforts nécessaires pour détecter les dérives et anomalies. Ils proposent une approche novatrice à la détection d’anomalies et de dérives en utilisant des LLMs, une réduction de la dimensionnalité UMAP, un clustering non-paramétrique et une visualisation des données. L’objectif est de détecter les observations de données intéressantes via des statistiques, des modèles ou des techniques d’apprentissage machine.

Afin d’illustrer cette approche, les auteurs ont utilisé le jeu de données de California Medium Home Values. Ils ont synthétisé de petites régions de données anormales en échantillonnant et en permutant les données. Les données synthétiques sont ensuite bien cachées dans les données de production existantes. Des expériences ont été menées en variant la fraction de points anormaux ainsi que le “degré d’anormalité” des données. La procédure visait ensuite à identifier les anomalies. Les auteurs ont finalement démontré que l’approche LLM permettait de détecter des régions anormales contenant aussi peu que 2% des données, avec une précision de 96,7%. Cette méthode peut être appliquée à des données de production sans étiquetage, comparaison de distribution manuelle ou beaucoup de réflexion. Le processus est entièrement libre de paramètres et de modèles et constitue une première étape intéressante pour la détection d’anomalies.

L’un des défis courants de l’observabilité des modèles est d’identifier rapidement et visuellement les données inhabituelles. Ces anomalies peuvent résulter d’une évolution naturelle des données ou d’une sous-population de données inattendue. Les anomalies peuvent résulter de nombreux facteurs, mais deux sont très courants : les changements non annoncés de sources de données ou les comportements malveillants d’adversaires. La détection de dérives qui se concentrent sur les données multivariées présente de nombreux défis. Les approches typiques incluent l’utilisation d’Auto-encodeurs variationnels (VAE), la réduction dimensionnelle ou la combinaison de données brutes non encodées en un vecteur. Cela nécessite souvent la modélisation des anomalies passées, la création de fonctionnalités et la vérification des (in)cohérences internes. Ces techniques nécessitent constamment de (re)former un modèle et de l’adapter à chaque ensemble de données. En outre, les équipes doivent généralement identifier, définir et ajuster un certain nombre de paramètres à la main. Cette approche peut être lente, fastidieuse et coûteuse.

Dans cet article, les auteurs appliquent les LLMs à la tâche de détection d’anomalies dans les données tabulaires. Cette méthode présentée est particulièrement avantageuse en raison de sa facilité d’utilisation. Aucune formation de modèle supplémentaire n’est nécessaire, la réduction de la dimensionnalité rend l’espace du problème graphiquement représentable et le cluster produit un candidat de cluster anormal. Les LLMs préformés permettent de contourner le besoin pour la paramétrisation, la création de fonctionnalités et la formation de modèle dédiée, ce qui est attrayant pour les équipes de sciences des données.

En synthétisant des données anormales, les auteurs ont affecté les trois variables suivantes dans une expérience : le nombre d’observations anormales, le degré d’anormalité et le nombre de dimensions. Plus il y a de données anormales, plus la détection est facile. Plus les anomalies sont décentrées de la distribution de référence, plus la détection est difficile. Enfin, le nombre de dimensions utilisées sur lesquelles les anomalies sont définies est également crucial.

La procédure de détection d’anomalies se déroule en fournissant des prompts aux LLMs. Les auteurs ont utilisé le jeu de données California Home Values, et pour chaque ligne/observation, le prompt se composait de la valeur de chaque cellule de la ligne (uniquement pour la détection d’anomalies, pas pour l’entraînement du modèle). La réponse textuelle du modèle est ignorée. Les auteurs ont démontré que cette méthode pouvait détecter des anomalies cachées dans des distributions d’observations. La possibility pour le prompt de se concentrer sur des zones particulièrement pertinentes pour la détection d’anomalies ou la métrique de classification de l’anomalie sont des domaines de recherche supplémentaires.