[ad_1]

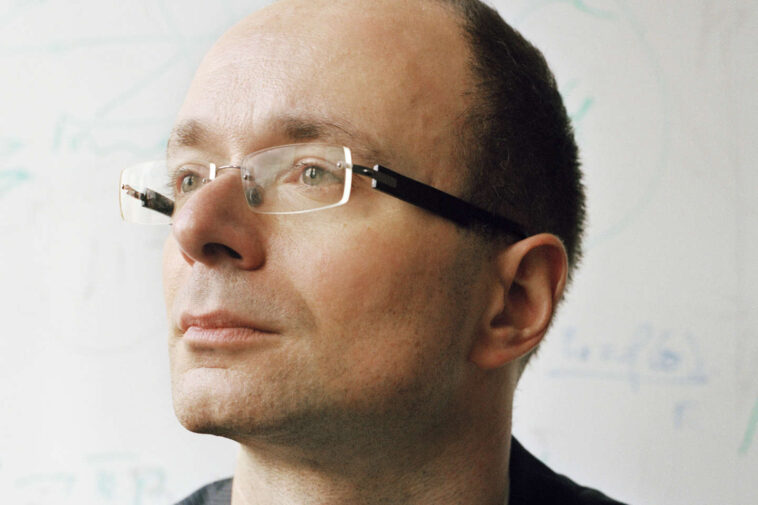

Alexei Grinbaum est physicien et philosophe au Commissariat à l’énergie atomique et aux énergies renouvelables (CEA). Membre du Comité national pilote d’éthique du numérique, il alerte sur les progrès, à la fois fascinants et inquiétants, en matière de génération automatique de langage. En particulier, il revient pour Le Monde sur les déclarations d’un employé de Google, Blake Lemoine, dans le Washington Post du 11 juin. Après avoir conversé avec le dernier algorithme de traitement du langage naturel de l’entreprise, LaMDA, cet ingénieur a expliqué avoir cru dialoguer avec une intelligence humaine à qui il attribue la sensibilité d’un enfant de 7-8 ans. La révélation des détails des conversations a dévoilé les progrès considérables de Google en matière de langage, et relancé les débats sur les capacités des machines. Pour avoir, selon l’entreprise, enfreint sa politique de sécurité, Blake Lemoine a été licencié le 22 juillet.

Que vous inspire cette affaire de conversation réaliste avec une intelligence artificielle ?

On sait depuis 1965, et le premier chatbot [agent conversationnel], Eliza, que les machines parlantes peuvent avoir des effets psychologiques sur les utilisateurs. Eliza était un système déterministe, assez trivial, dont la stratégie était de transformer des affirmations en questions pour relancer la conversation. Avec les systèmes d’intelligence artificielle (IA) actuels, la stratégie est différente, mais Blake Lemoine subit aussi des effets : il est dans l’illusion que cette machine a des émotions, des états d’âme… Or, savoir qu’il s’agit d’une machine ne l’empêche pas de faire, très sérieusement, des projections de qualités humaines sur LaMDA. Il projette des ressentis, comme nous le faisons parfois avec notre voiture chérie ou notre malicieux smartphone…

« LaMDA s’approche de l’humain parce qu’elle crée aussi l’illusion de posséder un libre arbitre »

L’illusion est quand même presque parfaite, non ?

La particularité est que cette illusion vient du langage, sans avoir besoin de recourir à une jolie figure humanoïde, tel le robot Sophia. LaMDA écrit du texte, et cela suffit pour la projection de traits humains. Il faut rappeler qu’au Moyen Age, un « monstre » pouvait être baptisé s’il remplissait un des trois critères : la paternité humaine, le visage humain ou le langage. Du moment qu’une entité étrange parle en notre langue, s’établit automatiquement une relation avec l’interlocuteur humain. Dans les mythes, les agents non humains qui nous parlaient étaient des dieux, des démons ou des anges. Désormais, on interagit avec des prouesses techniques, des machines parlantes.

Il vous reste 75.59% de cet article à lire. La suite est réservée aux abonnés.

[ad_2]